Docker部署GPT

AI-摘要

Fsx GPT

AI初始化中...

介绍自己

生成本文简介

推荐相关文章

前往主页

前往tianli博客

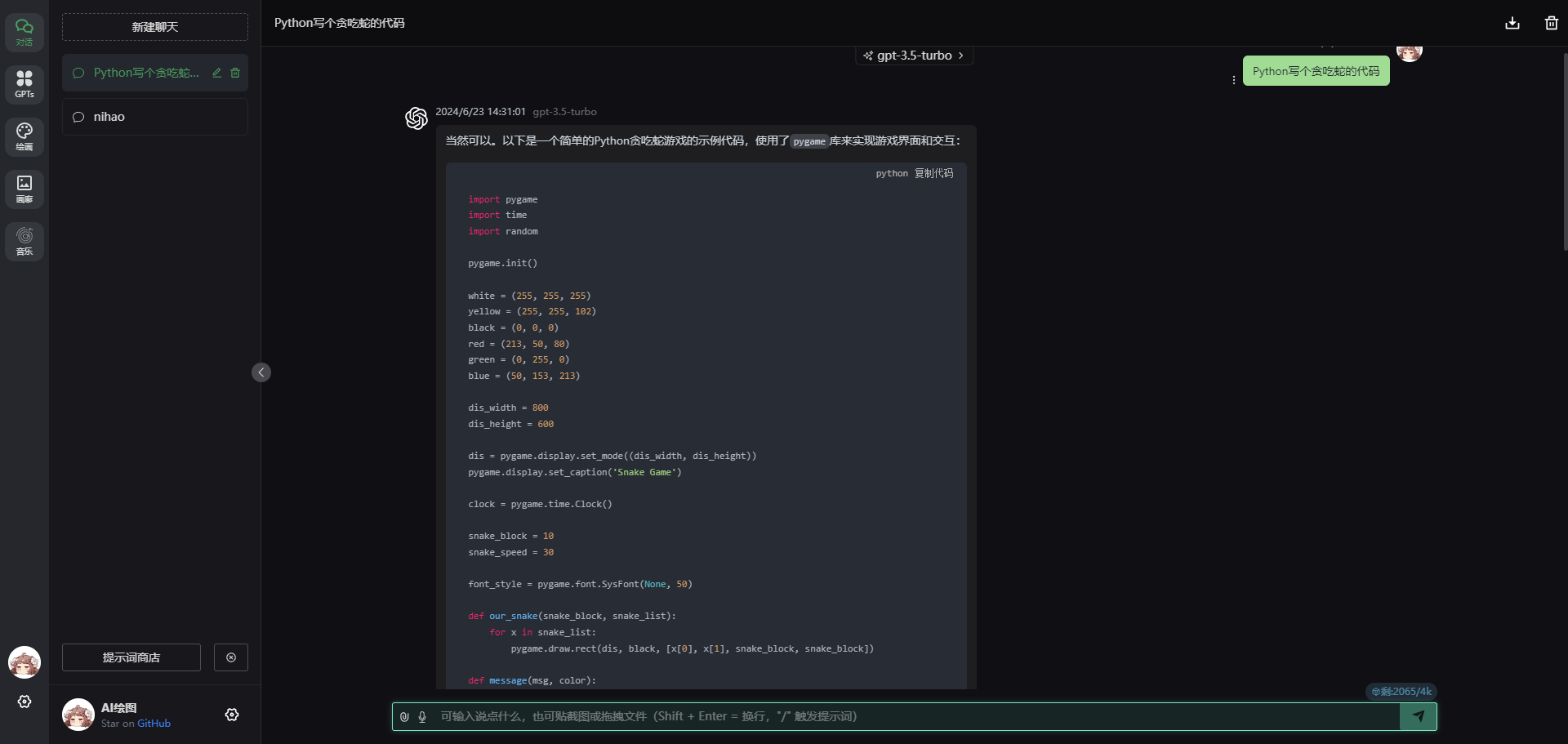

chatgpt-web-midjourney-proxy

同时支持 chatgpt-web 和 midjourney 画图

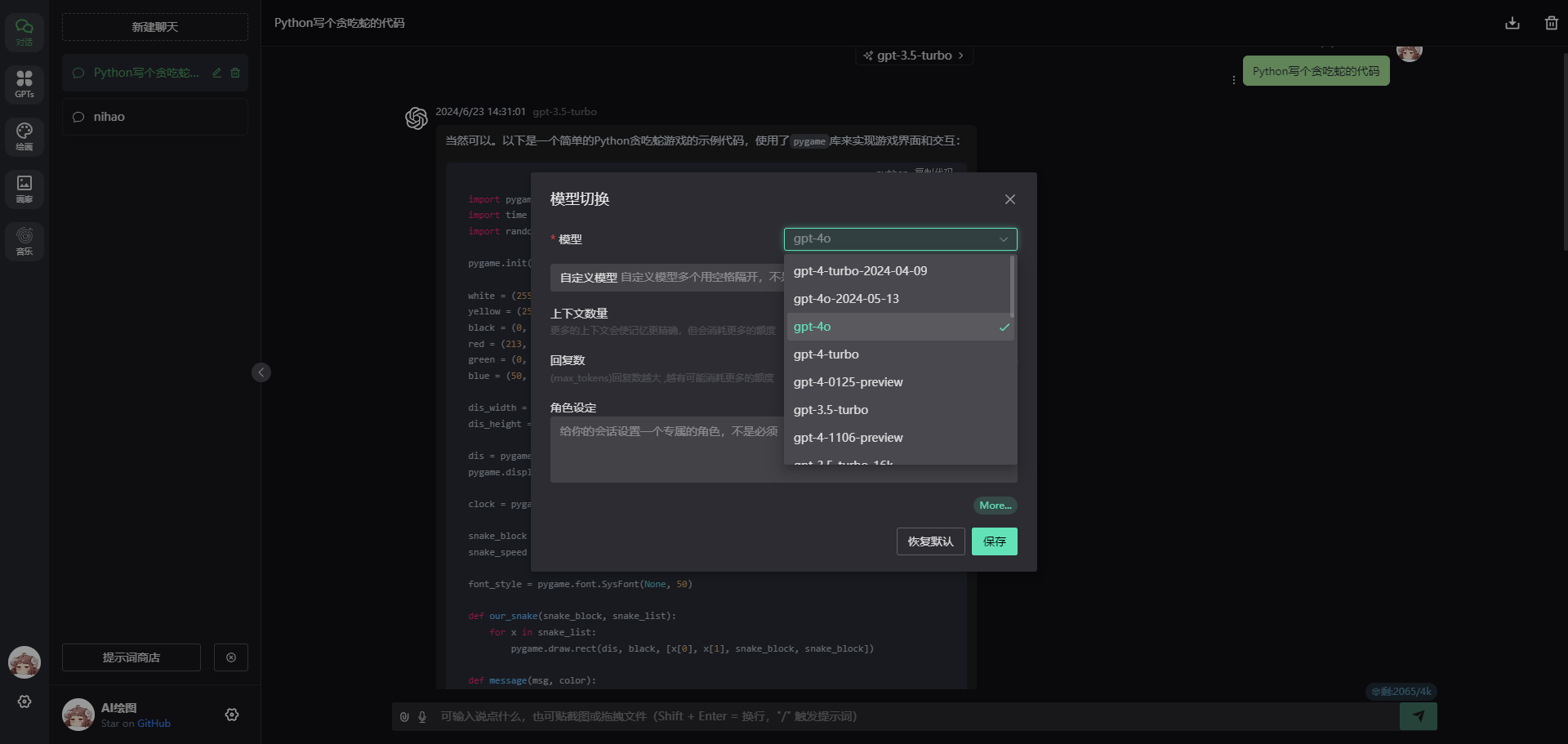

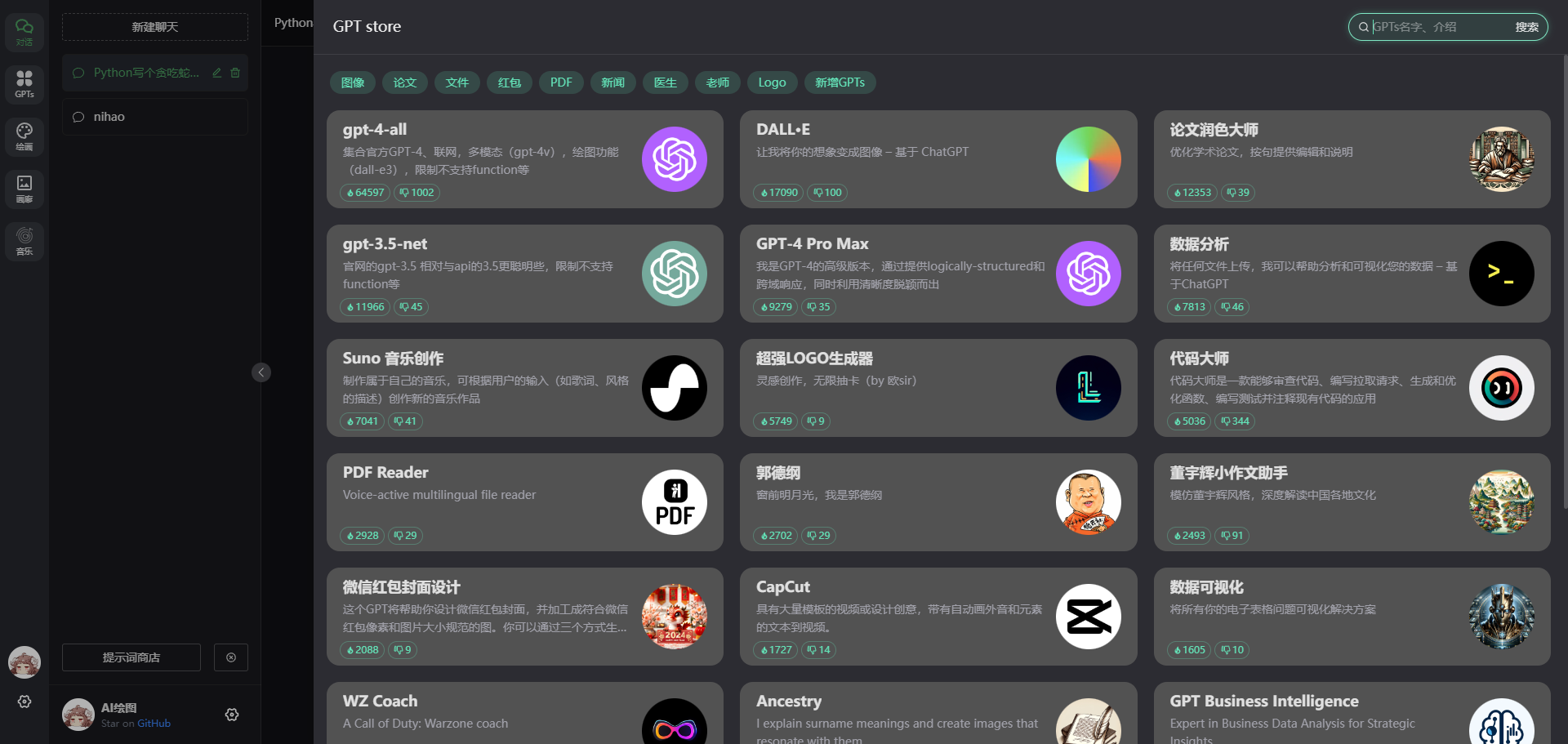

支持 GPTs多模态

支持 whisper语言输入 tts 文字转语音

支持 绘图

dall-emidjourney

安装

docker run --name chatgpt-web-midjourney-proxy -d -p 6015:3002 \

-e OPENAI_API_KEY= #sk-你的apiKey \

-e OPENAI_API_BASE_URL= #你的api接口地址 \

-e MJ_SERVER= #你的api接口地址 \

-e AUTH_SECRET_KEY= #访问授权密码-需要英文字母和数字 \

-e MJ_API_SECRET=sk-你的apiKey ydlhero/chatgpt-web-midjourney-proxy然后访问http://ip:6015

效果图

更新

docker pull ydlhero/chatgpt-web-midjourney-proxy #更新需要

docker rm -f chatgpt-web-midjourney-proxy #更新需要

docker run --name chatgpt-web-midjourney-proxy -d -p 6015:3002 \

-e OPENAI_API_KEY=hk-你的apiKey \

-e OPENAI_API_BASE_URL=你的api接口地址 \

-e MJ_SERVER=你的api接口地址 \

-e AUTH_SECRET_KEY=访问授权密码-需要英文字母和数字 \

-e MJ_API_SECRET=hk-你的apiKey ydlhero/chatgpt-web-midjourney-proxy注释

点击展开注释

这段命令是用于在 Docker 中拉取、运行和配置一个名为 "chatgpt-web-midjourney-proxy" 的容器。这个容器似乎是用于连接到一个中间件服务器,以便访问 OpenAI 的 GPT 模型。以下是对每个命令和参数的详细解释:

-

docker pull ydlhero/chatgpt-web-midjourney-proxy: 这个命令用于从 Docker Hub 上拉取名为 "chatgpt-web-midjourney-proxy" 的镜像。Docker Hub 是一个用于存储和分享 Docker 镜像的平台。 -

docker rm -f chatgpt-web-midjourney-proxy: 这个命令用于强制删除名为 "chatgpt-web-midjourney-proxy" 的容器(如果存在)。这是为了确保在启动新容器之前,旧容器已经被停止并删除。 -

docker run --name chatgpt-web-midjourney-proxy -d -p 6015:3002 \:

--name chatgpt-web-midjourney-proxy: 指定了容器的名称为 "chatgpt-web-midjourney-proxy"。-d: 表示在后台运行容器,即以守护进程模式运行。-p 6015:3002: 指定了容器的端口映射,将容器内部的端口 3002 映射到宿主机的端口 6015。

-

-e OPENAI_API_KEY=hk-你的apiKey \: 这一行设置了名为 OPENAI_API_KEY 的环境变量,其值为你的 OpenAI API 密钥。 -

-e OPENAI_API_BASE_URL=你的api接口地址 \: 这一行设置了名为 OPENAI_API_BASE_URL 的环境变量,用于指定 OpenAI API 的基本 URL 地址。 -

-e MJ_SERVER=你的api接口地址 \: 这一行设置了名为 MJ_SERVER 的环境变量,似乎也是用于指定 API 的服务器地址。 -

-e AUTH_SECRET_KEY=访问授权密码-需要英文字母和数字 \: 这一行设置了名为 AUTH_SECRET_KEY 的环境变量,用于设置访问授权密码。 -

-e MJ_API_SECRET=hk-你的apiKey: 这一行设置了名为 MJ_API_SECRET 的环境变量,其值似乎也是你的 API 密钥。 -

ydlhero/chatgpt-web-midjourney-proxy: 最后一个参数是要运行的镜像的名称。在这里,它指定了要运行的 "chatgpt-web-midjourney-proxy" 镜像。

通过这些命令和参数,你可以在 Docker 中拉取、配置并运行一个包含了中间件服务器的容器,以便连接到 OpenAI 的 GPT 模型。

本文是原创文章,采用 CC BY-NC-ND 4.0 协议,完整转载请注明来自 老朝奉

评论

匿名评论

隐私政策

你无需删除空行,直接评论以获取最佳展示效果